萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

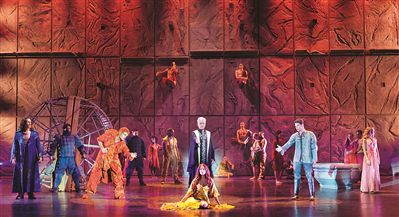

【资料图】

【资料图】

聊天、读书或听讲时,你有意识到自己正在疯狂“脑补”吗?

其实,你的大脑就像一个自动补全机一样,每时每刻都在猜别人要说什么。

不仅如此,大脑还会不断地将我们从外界获取的信息(图像、声音和文本等)与脑内的预测进行比较。

基于这一理论,研究人员搞出了不少NLP模型,包括语音识别、自动补全等,但他们却发现,人的“脑补”能力还是比这些AI更优秀。

所以,究竟是不是人的大脑和AI“脑补”的方法不一样?

现在,一群来自马普所和奈梅亨大学(Radboud University)的科学家,决定直接测一测人们“脑补”时发出的脑电波。

对这些脑电波特征进行分析后,他们发现了背后更详细的原因。

收集大脑听书时的“反应”

此前,科学家们已经发现,大脑会对外界事物进行预测,来引导自己处理信息。

但大脑究竟是基于哪些条件(词类/音素/语义等)做出的预测,不同条件之间是否会相互影响,一直没有明确定论。

例如,单词和语义究竟是怎么影响大脑预测的,预测单词会不会对语义造成影响,都还不清楚。

因此,科学家们想出了一个方法:让志愿者们听有声书,观察他们的大脑反应,并采用GPT-2来对预测内容进行一个定量分析,将预测结果进行对比。

他们先找来19名志愿者,测量并记录他们1小时的脑电波(EEG);随后,又收集了3名志愿者9小时的脑磁图(MEG),来定位大脑中具体位置的神经活动。

其中,脑电波小组听的是一小时《老人与海》,每次时长180秒,一共播放20次;脑磁图小组听的是9个小时《福尔摩斯探案集》,每次1小时,并被要求在两次间隔之间回答具体问题。

随后,从不同维度对这些数据进行分析,并得出了几点结论。

优先考虑“更高级”的预测条件

研究人员先是验证发现,大脑的预测是持续不断地产生的。

在这个过程中,科学家们也发现了AI预测和人脑的相似性。

例如,如果预测结果不符合实际情况(猜错了),大脑就会感到“惊奇”,变得空前活跃。

随后,他们将有声书的内容分成几个层次,包括词性(动词/名词/形容词)、音素(音标)和语义(用GPT-2做预测)这几个“级别”。

然后,通过MRI还原了大脑在进行不同层次预测时的“可视化图”。

结果显示,大脑在用词性、语义和音素进行预测时,不同层次之间会相互进行影响。

也就是说,更“高级”的预测条件会影响优先级较低的预测条件,如语义(上下文)就会对音素预测产生影响。

例如在“They say his father was a _____.”这句话中,如果仅仅凭借音素预测下一个音节,和通过上下文进行预测的结果是不一样的。

如果只用音素和频率进行预测,大概率会认为单词音标会以/fɔ/开头,但结合上下文的话,就更容易做出“fisherman”,也就是/fi/开头的单词预测。

这样看来,或许也能通过将几个层次的预测条件结合起来,增加语音识别或自动补全等AI的准确性。

作者介绍

一作Micha Heilbron,目前是内梅亨大学和马普所研究院,研究方向是认知和计算神经科学,对于生成模型对语言处理中的作用感兴趣。

Kristijan Armeni,目前在约翰霍普金斯大学读博后,博士毕业于内梅亨大学,研究方向是自然语言处理和认知神经科学。

同样参与研究的几名作者Jan-Mathijs Schoffelen、Peter Hagoort、Floris P. de Lange也分别来自内梅亨大学和马普所。

对于这项研究,有网友提出了自己的观点,即大脑本身就是一种机制,会基于一种反馈回路做出决策和行动。

但也有网友从自己感受来看,大脑这个“预测机器”似乎经常出错。

对此有网友提出了自己的观点:

毕竟大脑是个生存机器,而不是“真相检测仪”。如果说谎能促进健康,那么你的大脑便会选择说谎。

营业执照公示信息

营业执照公示信息